Wer braucht einen Gebrauchtwagen ![]()

Apple Vision Pro (Apples AR/VR Brille) | Von den Gerüchten, zur offiziellen Vorstellung und darüber hinaus

-

-

-

Stimmt.

Ich hab schon ein Auto und brauche nicht noch eins.

Bei meinen Smartphones würde ich das allerdings so nicht behaupten.

-

Apple arbeitet möglicher Weiße an 2 Datenbrillen

Bloomberg (Quelle) berichtet unter Verweis auf mit der Angelegenheit vertraute Personen in ihrem neuesten Artikel über die Apple Brille nun folgendes:

Apple arbeitet wohl an zwei intelligenten Brillen, deren Marktstart eigentlich für 2022 geplant war, die aufgrund zahlreicher Entwicklungshürden nun jedoch nacheinander in den Markt eingeführt werden sollen.

Apple soll vorhaben mit einem teuren Edel-Set in den Markt zu starten, dass mit einer ähnlich hohen Preisauszeichnung wie der Mac Pro versehen sein wird und eher auf Entwickler als auf den breiten Massenmarkt zielt.

Mit zeitlichem Abstand wird dann eine günstigere Brille folgen, die das Mixed-Reality-Headset als Produkt in Apples Lineup etablieren wird und sich an alle iPhone-Nutzer richtet.

Zwei 8K-Displays und Wechsel-Bänder

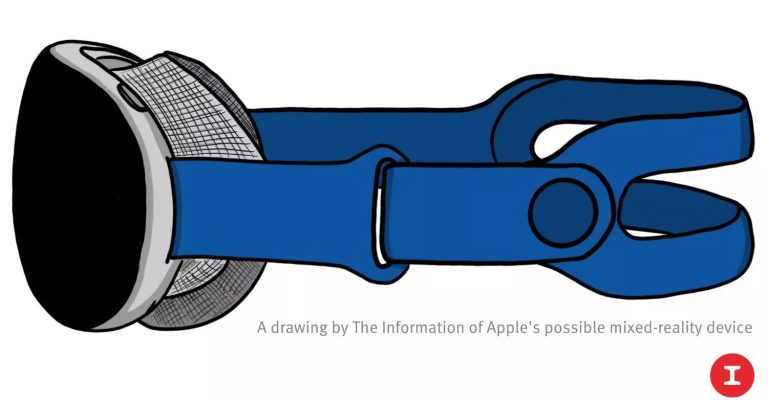

Zum teuren Auftakt-Modell präzisiert The Information jetzt: Der Marktstart des Ultra-High-End-Modells sei 2022 geplant. Hier werde Apple einen überdurchschnittlichen hohen Produktpreis von 3000 US-Dollar ansetzen. Zudem behauptet The Information, dass die Mixed-Reality-Brille mit zwei 8K-Display ausgestattet sein wird, einen integrierten LIDAR-Sensor mitbringt und über ein Dutzend Kameras für das Hand-Tracking integriert. Die Bänder des Headsets werden sich wechseln lassen.

Die den Bericht flankierende Skizze erinnert dabei an die Armbänder der Apple Watch.

-

Und weiter geht's - jetzt ist es bestätigt.

Apple arbeitet tatsächlich an einer Videobrille.

(Ich nenne sie mit Absicht nicht mehr VR oder AR-Headset, da noch immer nicht zu 100% sicher ist, um welche Art von Brille es sich im Endeffekt handeln wird.)

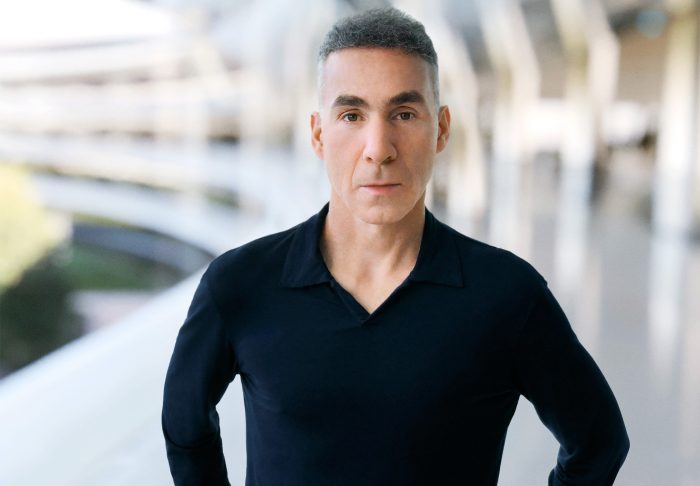

Dan Riccio hat laut Apple bereits 1998 ein neues Kapitel bei Apple gestartet.

Am 8. Februar 2021 berichtet der Wirtschaftsnachrichten-Dienst Bloomberg unter Berufung auf mit der Angelegenheit vertraute Personen dieser, dass Riccio fortan den Bau der Mixed-Reality-Headsets beaufsichtigen werde, die Apple-intern bereits in zwei Varianten vorliegen sollen. Einer rund $3000 teuren Virtual-Reality-Edition, die auf Entwickler und Early Adopter abzielen würde und bereits im kommenden Jahr in kleinen Stückzahlen in den Markt starten soll und einer Augmented-Reality-Brille für den Massenmarkt.

Schon 2022: Apples Mixed-Reality-Headset startet für $3000

Bericht: Apples AR-Brille kämpft mit Entwicklungshürden

Über 1000 Ingenieure im Einsatz

Bereits in seiner bisherigen Rolle soll Riccio, der seit 1998 bei Apple arbeitet, die Verantwortung für die Hardware-Entwicklung der Headsets getragen haben, soll sich seit dem Rückzug aus seiner bisherigen Rolle im Unternehmen nun jedoch ausschließlich auf die neuen Produkte konzentrieren.

Apples Arbeit an seinem ersten Headset, einem High-End-VR-Gerät mit einigen AR-Funktionen, stand vor Entwicklungsherausforderungen, und Leute innerhalb von Apple glauben, dass Riccios zusätzlicher Fokus hier helfen könnte. Während er die letztendliche Aufsicht über das Projekt hat, wird es tagtäglich von Mike Rockwell geleitet, einem Apple-Vizepräsidenten, der weit über tausend Ingenieure an den beiden Geräten arbeiten lässt.

-

Möglicher Weiße wird Apple bereits auf der diesjährigen WWDC in den Bereich der AR-Technik vorstoßen.

Das könnte man jedenfalls meinen, wenn man sich so die Teasergrafik ansieht:

-

Noch hat sich nichts weiter an der AR/VR-Front bei Apple getan, aber es könnte recht bald losgehen.

-

Ein Bericht sagt, dass das angebliche Apple-Headset mit kombinierten AR-VR-Funktionen hinter dem Zeitplan zurückgefallen ist.

Der Bericht besagt, dass die Lieferkettenpartner erwarteten, dass das Gerät im letzten Quartal in eine zweite Phase der Prototyptests übergeht, aber dies ist nicht geschehen.

Es ist jedoch unklar, dass der Behauptung viel Gewicht beigemessen werden sollte ...

Apple hat im ersten Quartal 2021 nicht mit den P2-Prototyptests für seine AR-Brille begonnen, wie von seinen Lieferkettenpartnern erwartet, was bedeutet, dass es laut Branchenquellen unwahrscheinlich ist, dass das Gerät im ersten Quartal 2022 mit der Serienproduktion beginnt.

Das ist etwas zweideutig, da angenommen wird, dass Apple an zwei separaten - und sehr unterschiedlichen - Produkten in diesem Bereich arbeitet.

Das erste ist ein kombiniertes Virtual Reality/Augmented Reality Headset, ähnlich wie das HoloLens 2 von Microsoft. Dies ist im Wesentlichen ein VR-Headset mit externen Kameras, um ihm auch AR-Funktionen zu verleihen.

Das zweite ist ein reines AR-Gerät mit einem Formfaktor, der viel näher an traditionellen Gläsern liegt. Dies ist das Gerät, das als Apple Glasses bezeichnet wird und Berichten zufolge nur als Begleitgerät zum iPhone in ähnlicher Weise wie die ersten Generationen der Apple Watch funktionieren wird.

-

Laut einem neuen Bericht müssen Apples erwartetes Virtual Reality- und Augmented-Reality-Headset drahtlos an ein Telefon oder ein ähnliches Gerät gebunden werden, um die fortschrittlichsten Funktionen zu erhalten.

Die Informationen sagen, dass dieses AR/VR-Headset ähnlich wie frühe Versionen der Apple Watch funktionieren wird, bei denen Benutzer ihre iPhones mit sich führen mussten.

-

Analyst Ming-Chi Kuo ist der Meinung, dass das AR/VR-Headset von Apple aufgrund seines komplexen Designs voraussichtlich mit Produktionsverzögerungen konfrontiert sein wird.

612DE519-2487-4033-A181-3D1B90EFDFE1.jpeg

Kuo behauptet, dass die Anforderungen von Apple an das Industriedesign für das neue Head-Mounted-Display "viel höher sind als die Produkte der Wettbewerber".

Der Analyst sagt, dass Apple beim Start ein solides Ökosystem von Hardware, Software und Dienstleistungen haben möchte. Infolgedessen könnte sich das Produkt verzögern.

Basierend auf Quellen in der Lieferkette von Apple glaubt Ming-Chi Kuo, dass die Massenproduktion des neuen Apple-Headsets im vierten Quartal 2022 beginnen wird, während es zuvor für das zweite Quartal 2022 geplant war. Er sagt auch, dass Taiwans Young Optics, einer der möglichen Komponentenlieferanten für Apples neues Gerät, stark von der Verzögerung betroffen sein wird.

In der Investorennotiz wird auch erwähnt, dass Apple sein Mixed-Reality-Headset nicht nur als Spielgerät positionieren möchte, sondern auch als etwas, das für andere Anwendungskategorien bereit ist.

Laut Kuo wird erwartet, dass die Lösung von Apple "das bisher beste Industriedesign" haben wird.

-

Der zuverlässige Analyst Ming-Chi Kuo ist zurück mit einem weiteren Anspruch über Apples kommendes AR/VR-Headset.

Nachdem Kuo gesagt hat, dass das Gerät aufgrund seines komplexen Designs voraussichtlich mit Produktionsverzögerungen konfrontiert sein wird, hat er jetzt in einer erwähnt, dass das Produkt Wi-Fi 6E-Unterstützung für höhere Bandbreite und niedrige Latenz bieten wird.

Wie der Analyst erklärte, ist eines der größten Probleme bei Mixed-Reality-Headsets derzeit die Anforderung einer kabelgebundenen Verbindung zu einem Computer. Um diese Probleme zu vermeiden und den Benutzern eine bessere Erfahrung zu bieten, wird erwartet, dass Apples Headset das Wi-Fi 6/6E-Protokoll unterstützt.

Wie der Analyst erklärte, ist eines der größten Probleme bei Mixed-Reality-Headsets derzeit die Anforderung einer kabelgebundenen Verbindung zu einem Computer. Um diese Probleme zu vermeiden und den Benutzern eine bessere Erfahrung zu bieten, wird erwartet, dass Apples Headset das Wi-Fi 6/6E-Protokoll unterstützt.

Jetzt mitmachen!

Sie haben noch kein Benutzerkonto auf unserer Seite? Registrieren Sie sich kostenlos und nehmen Sie an unserer Community teil!